Klikerowe szkolenie psów. Uczenie się poprzez warunkowania

2. UCZENIE SIĘ POPRZEZ WARUNKOWANIA

2.1. ROZWÓJ KLIKEROWEJ METODY SZKOLENIA PSÓW

Od wieków pies towarzyszy człowiekowi. Dzięki wierności i przywiązaniu zdobył miano najwierniejszego przyjaciela człowieka. Pies charakteryzuje się dobrą zdolnością uczenia się, zapamiętywania oraz szerokim repertuarem zachowań. Dzięki tym cechom ludzie wykorzystują psy do szkoleń podstawowych, które mają ułatwić współprace z właścicielem w codziennym życiu, jak i szkoleń specjalistycznych [Kaleta 1999]. Szkolenie psów stało się bardzo popularne. Powstało wiele ośrodków szkolących psy, co za tym idzie powstało także wiele metod szkoleniowych. Najczęściej metody te polegają na stosowaniu kar i przymusu. Do dziś w ten sposób szkoli się psy, jednak metody te, zwane w kręgach szkoleniowych, tradycyjnymi, zaczynają być wypierane przez pozytywne metody szkolenia psów [Fisher 2002].

Jedną z nich jest metoda klikerowa, która została dokładnie opisana w rozdziale trzecim. Nie jest to metoda nowa, była stosowana na świecie od wielu lat. Okazywała się niezmiernie przydatna szczególnie w przypadku zwierząt, których nie da się nakłonić do współpracy poprzez stosowanie przymusu tj. np. delfiny [Pryor 1985].

W ostatnich latach metoda ta zdobyła popularność wśród osób zajmujących się szkoleniem psów. W Stanach Zjednoczonych była stosowana już w latach 30-tych, do Polski dotarła dopiero w latach 90-tych. Szybko zdobyła zwolenników, których grono wciąż się powiększa. Sednem metody jest nagradzanie zwierzęcia za pożądane zachowanie, które w skutek tego będzie powtarzane. Przewodnik używa języka doskonale przez zwierzę rozumianego, stosując wszystkie prawa związane z uczeniem się poprzez warunkowania.

2.2. TEORIE UCZENIA SIĘ

Uczenie się jest procesem powstawania, poprzez doświadczenie, względnie trwałych zmian w zachowaniu się organizmu. Zmiany te pozwalają na lepsze funkcjonowanie w danym środowisku. Wyróżnia się dwa podstawowe rodzaje uczenia się: warunkowanie klasyczne i warunkowanie instrumentalne. Poprzez warunkowanie klasyczne jednostki uczą się przewidywać pojawienie się ważnych wydarzeń w środowisku np. pojawienie się pokarmu, i przygotowywać się na nie. Natomiast poprzez warunkowanie instrumentalne jednostki uczą się, które z ich zachowań przynoszą korzystne, a które niekorzystne zmiany w środowisku. Uczą się więc, które reakcje warto powtarzać, a których unikać [Ostaszewski 2001].

2.3. WARUNKOWANIE KLASYCZNE

Warunkowanie klasyczne to proces, w którego przebiegu początkowo obojętny dla organizmu bodziec w wyniku długotrwałego podawania go wraz z bodźcem, który bez wcześniejszego uczenia wywołuje reakcję organizmu, nabiera także zdolności do wywoływania tej samej reakcji.

Warunkowanie klasyczne zostało odkryte przez rosyjskiego uczonego, Iwana Pawłowa. Badał on wydzielanie śliny u psów podczas karmienia. Pokarm jest naturalnym źródłem dla ślinienia się. Najpierw widok pożywienia wywoływał ślinienie u badanych psów, później widok eksperymentatora, który przynosił pokarm, a w końcu odgłos jego kroków wystarczył do wywołania ślinienia [Zimbardo 1994]. Aby potwierdzić te obserwacje Pawłow bezpośrednio przed karmieniem włączał dzwonek. Po kilku tego typu sesjach zaobserwował, że psy ślinią się już na sam dźwięk dzwonka. Dźwięk dzwonka wywoływał u nich takie same reakcje fizjologiczne, jak widok pożywienia.

Pokarm jest wrodzonym bodźcem bezwarunkowym (Sb), który wywołuje reakcję bezwarunkową (Rb), czyli ślinienie się. Natomiast bodziec, który w wyniku podawania go z bodźcem bezwarunkowym (pokarmem) wywołuje podobną reakcję (ślinienie) nazywa się bodźcem warunkowym (Sw) (dzwonek). Reakcja przez niego wywoływana jest reakcją warunkową (Rw).

Bodziec warunkowy sygnalizuje teraz pojawienie się bodźca bezwarunkowego. Gdy połączenie to zastanie wyuczone, organizm reaguje na dzwonek tak jakby to był pierwotny, silny bodziec.

Sb -> wywołuje -> Rb

(pokarm) (ślinienie)

Sw -> wywołuje -> Rw

(dzwonek) (ślinienie)

Pawłow zajmował się także warunkowaniem awersyjnym. Traktował łapę psa wstrząsem elektrycznym, stosując przy tym różne bodźce dźwiękowe i wzrokowe. Pies był w uprzęży, z której nie mógł się uwolnić, dlatego uniknięcie bolesnych wstrząsów było niemożliwe. Pies nie miał wpływu na odruch warunkowy. Reagował cofnięciem łapy, a także strachem [Zimbardo 1994]. Bodźcami warunkowymi mogą stać się bodźce fizyczne, jak również akustyczne i optyczne.

Jeżeli przed wystąpieniem bodźca bezwarunkowego nie będzie się pojawiać bodziec warunkowy, reakcja warunkowa będzie stopniowo zanikać. Zjawisko to nazwano wygaszaniem odruchu warunkowego [Ostaszewski 2001].

Zaobserwowano również, że jeżeli po wygaszeniu tego odruchu, użyje się takiego samego bodźca warunkowego, reakcja warunkowa zostanie wznowiona. Nazywa się to spontanicznym odnowieniem odruchu. Jeżeli następnie bodziec warunkowy ponownie przestanie być podawany, reakcja warunkowa szybko zaniknie (wygaśnie) [Ostaszewski 2000]. Natomiast badania Liddela (1934) wykazały, że w przypadku awersyjnego warunkowania nie wszystkie reakcje organizmu ulegną wygaszeniu. Reakcje emocjonalne (jak np. strach) mogą się utrzymywać przez czas nieograniczony [Zimbardo 1994].

W początkowej nauce reagowania na bodziec warunkowy, pojawia się wiele bodźców podobnych do właściwego, które także wywołują reakcję warunkową. Zjawisko to nosi nazwę generalizacji. Organizm musi nauczyć się rozróżniać, czyli różnicować bodźce istotne i nieistotne oraz hamować swoją reakcję na wszystkie inne bodźce nie związane z bezwarunkowym zdarzeniem bodźcowym. Im łatwiejszy do odróżnienia sygnał, tym szybciej zostanie zidentyfikowany [Zimbardo 1994].

Jeżeli przed bodźcem warunkowym podany zostanie inny, początkowo nieznany bodziec, zwierzę po pewnym czasie zacznie traktować ten bodziec jako warunkowy. Na przykład, Pawłow przez 10 sekund pokazywał psu czarny kwadrat, następnie pies słyszał dzwonek, czyli bodziec warunkowy wywołujący ślinienie. Po kilku takich sesjach czarny kwadrat wystarczył do wywołania u psa ślinienia [Skinner 1995]. Proces ten został nazwany warunkowaniem drugiego rzędu. Wywnioskowano z niego, że podczas przebiegu warunkowania klasycznego organizm uczy się związku między bodźcami warunkowymi a reakcjami warunkowymi. Do powstania odruchu warunkowego niezbędne jest wystąpienie zależności między bodźcem warunkowym a pojawieniem się bodźca bezwarunkowego. Najszybsze warunkowanie zachodzi gdy bodziec bezwarunkowy pojawia się zawsze po bodźcu warunkowym i nigdy nie występuje bez zapowiedzi w postaci bodźca warunkowego. Jeżeli bodziec bezwarunkowy występuje częściej bez bodźca warunkowego niż po nim, bodziec warunkowy nabiera znaczenia hamującego [Ostaszewski 2001]. Reakcja warunkowa pełni funkcję adaptacyjną. Przygotowuje organizm do przyjęcia bodźca bezwarunkowego. Na przykład, wydzielanie śliny na dźwięk dzwonka, który zapowiada pojawienie się pokarmu, ułatwia trawienie.

Dzięki warunkowaniu klasycznemu organizm uczy się odczytywania sygnałów, które umożliwiają przewidzenie wystąpienia określonego zdarzenia. Uczy się reagować na nie w odpowiedni sposób [Anderson 1998].

Uczenie się nie jest jednak ograniczone tylko do warunkowania powłowskiego. Organizmy uczą się także tego, jakie konsekwencje pojawiają się po wykonaniu określonych reakcji (zachowań). Pozwala im to samodzielnie kształtować i zmieniać środowisko, w którym żyją. Proces nabywania takich umiejętności nazywany jest warunkowaniem instrumentalnym, zwanym także warunkowaniem sprawczym.

.2.4. WARUNKOWANIE INSTRUMENTALNE

Zasadniczy wkład do badań nad warunkowaniem instrumentalnym wniósł Burrhus F. Skinner. Odkryte przez niego w latach trzydziestych dwudziestego wieku prawa uczenia się uznawane są w psychologii do dziś.

Skinner odkrył, że organizm uczy się wykonywania lub powstrzymywania się od wykonania danej reakcji w zależności od tego, jakie pojawiają się wraz z wykonaniem reakcji konsekwencje. Konsekwencje mogą być atrakcyjne, nazywane nagrodami lub awersyjne czyli kary. Warunkowanie instrumentalne tworzy ścisły związek pomiędzy zachowaniem i jego skutkami. Skinner wyróżnił cztery podstawowe rodzaje relacji :

1. wzmacnianie pozytywne (R+), czyli każda konsekwencja zachowania, która powoduje zwiększenie się prawdopodobieństwa powtórzenia się tego zachowania w przyszłości [Ostaszewski 2001].

np. pies dostaje nagrodę w chwili, gdy usiądzie - zwiększa to szansę na ponowne siadanie psa.

2. pozytywne wygaszanie (P+) nazywane potocznie karą, czyli każda konsekwencja zachowania, która zmniejsza prawdopodobieństwo pojawienia się tego zachowania w podobnych warunkach w przyszłości [Ostaszewski 2001].

np. uderzenie psa w chwili, kiedy położy się na boku zmniejsza szansę jego ponownego położenia się na boku w podobnych warunkach.

3. negatywne wzmacniania (R-), czyli takie wykonanie reakcji, które pozwala uniknąć przykrych, awersyjnych konsekwencji, co powoduje zwiększenie się prawdopodobieństwa powtórzenia tej reakcji w przyszłości [Ostaszewski 2001].

np. szarpanie psa na smyczy, gdy stoi, co powoduje jego siadanie w celu uniknięcia szarpania.

4. wygaszanie ujemne (P-) nazywane także pomijaniem, jeśli po wystąpieniu zachowania nie pojawiają się konsekwencje, które wystąpiłyby gdyby ta reakcja nie powstała. Z otoczenia zastaje usunięty czynnik, którego brak zmniejszy prawdopodobieństwo powtórzenia danego zachowania [Ostaszewski 2001],

np. odwrócenie się i odejście od psa gdy ten skacze na właściciela, co zmniejsza prawdopodobieństwo ponownego skakania

2.4.1. BODŹE KONTROLUJĄCE

Jak już wiadomo, jeżeli wytwarzana jest pewna reakcja sprawcza i następuje po niej bodziec wzmacniający (Sr), prawdopodobieństwo ponownego wystąpienia tej reakcji wzrasta.

R -> Sr

Bodziec, który kontroluje zachowanie, czyli tak zwany bodziec kontrolujący, zmienia prawdopodobieństwo wystąpienia reakcji instrumentalnej. Bodźce kontrolujące pełnią role adaptacyjną dzięki możliwości przewidywania przez organizm konsekwencji jego działania w określonych warunkach. W obecności bodźca kontrolującego częstość występowania reakcji sprawczej może być większa lub mniejsza niż w przypadku braku tego bodźca. Wyróżnia się dwa typy bodźców kontrolujących: bodźce dyskryminacyjne (Sd) oraz wygaszeniowe (Sd) [Ostaszewski 2001].

Bodźce dyskryminacyjne informują dany organizm, że po wykonaniu reakcji pojawi się wzmocnienie czyli nagroda lub kara.

Jak pisze Zimbardo: "Bodziec dyskryminacyjny stwarza warunki czy daje sposobność organizmowi, by wytwarzał on reakcję sprawczą, która jest jednak reakcją dowolną".

Bodziec dyskryminacyjny sygnalizuje, kiedy wykonać daną reakcję, aby uzyskać wzmocnienie. Na przykład w klatce szczura wyposażonej w dźwignię, której naciśnięcie powoduje podanie pokarmu, ale tylko w obecności zapalonej lampki, bodźcem dyskryminacyjnym jest paląca się lampka. Początkowo szczur naciska dźwignię przez cały czas, kojarząc naciskanie z otrzymaniem pokarmu. Z czasem jednak uczy się, że pokarm pojawia się tylko gdy jest zapalona lampka, inaczej naciskanie dźwigni nie powoduje pojawienia się pokarmu. Szczur uczy się dyskryminować te bodźce, które są sygnałami czynników wzmacniających. W obecności bodźca dyskryminacyjnego po reakcji sprawczej następuje bodziec wzmacniający.

Sd R -> Sr

Bodźce wygaszeniowe informują, że po wykonanej reakcji nie pojawi się wzmocnienie. Prawdopodobieństwo wystąpienia danego zachowania spada. Na przykład, jeżeli zmieni się znaczenie palącej się lampki tzn. w obecności zapalonej lampki pokarm nie będzie się pojawiał to stanie się ona bodźcem wygaszeniowym. Szczur przestanie naciskać dźwignie, gdy będzie zapalona lampka.

2.4.2. GENERALIZACJA I RÓŻNICOWANIE BODŹCÓW

W warunkowaniu instrumentalnym, podobnie jak w klasycznym, następuje generalizacja bodźca. Jest to zjawisko uogólnienia reakcji na bodźce, które nie wystąpiły podczas pierwotnej sytuacji uczenia się. Bodźce te muszą być podobne do bodźców pierwotnych.

Np. gołąb, który nauczył się uderzać dziobem w narysowane kółko, może reagować także na narysowany owal. Jeżeli nie reaguje na owalną figurę znaczy, że wzmocnione zostało dziobanie koła czyli nastąpiło różnicowanie bodźców. Gołąb dostawał tylko pokarm za dziobanie w koło, nauczył się, że dziobanie w inne elementy nie przynosi korzyści [Tavris, Wode 1999].

2.4.3. POJĘCIE WZMACNIANIA

Wzmocnienie jest oddziaływaniem polegającym na podawaniu określonego bodźca skorelowanego z innym bodźcem lub reakcją. Wzmacnianie jest jednym z najważniejszych działań zwiększających podobieństwo pojawiania się pożądanych reakcji.

Behawioryści przez długi okres zastanawiali się nad tym, co sprawia, że czynnik wzmacniający wzmacnia. Opierano się na teorii redukcji popędu. Popęd uważa się za podstawową energię potrzebną do wykonania reakcji. Popędami są więc: jedzenie, picie, kontakty seksualne, unikanie bólu. Zachowania, które redukują lub zaspokajają popędy są wzmacniające dla organizmu [Anderson 1998].

Skinner badał warunkowanie sprawcze na przykładzie białych szczurów, a później gołębi. Skonstruował do tego celu słynną skrzynkę nazwaną skrzynka Skinnera. Była to dźwiękoszczelna komora z dźwignią, której naciśnięcie lub uderzenie dziobem powodowało pojawienie się nagrody w postaci pokarmu. Skrzynka była wyposażona w urządzenie rejestrujące reakcje badanych zwierząt [Myers 2003]. Badał szybkość naciskania dźwigni u szczurów, które pierwszy raz znalazły się w skrzynce. Naciskały one dźwignię zaledwie kilka razy w ciągu godziny z nieregularną szybkością. Natomiast gdy skorelował tą reakcję z bodźcem wzmacniającym w postaci dźwięku z pojemnika, z którego wypada pokarm, to szybkość wzrosła. Warunkiem uzyskania maksymalnego wzmocnienia reakcji na dźwignię jest wykształcenie reakcji różnicującej na dźwięk z pojemnika z pokarmem. Szczur uczy się rozróżniać tackę pustą od tacki pełnej, przy której występuje dźwięk. W dniu warunkowania pierwsza reakcja wystąpiła 5 minut po wpuszczeniu szczura do skrzynki. Wzmocnienie nie wywarło zauważalnego wpływu na jego zachowanie. Druga reakcja pojawiła się 51,5 min. później i też nie stwierdzono szczególnego wpływu wzmocnienia na zachowanie. Trzecia reakcja wystąpiła 47,5 min. później, czwarta zaś 25 min. po niej. Po czwartej reakcji stwierdzono znaczne zwiększenie szybkości i gwałtowne przyśpieszenie naciskania dźwigni. Przerwy przed piątą, szóstą i kolejnymi reakcjami wynosiły odpowiednio: 43;21;10;10 i 15 sekund. Od tego momentu szczur reagował ze stałą szybkością. W pewnym momencie dostrzegalny jest spadek szybkości reagowania na dźwignię tzw. przyśpieszenie ujemne. Spowodowane jest to zmianą poziomu głodu [Skinner 1995].

Wyróżnia się dwa rodzaje czynników wzmacniających:

- pierwotny czynnik wzmacniający, czyli bodziec o naturalnym działaniu wzmacniającym, przede wszystkim zaspokajający potrzeby fizjologiczne np. pożywienie

- wtórny czynnik wzmacniający, czyli bodziec, który nabiera właściwości wzmacniających przez skojarzenie z pierwotnymi czynnikami wzmacniającymi np. dźwięk dzwonka, pieniądze, pochwała, dobre stopnie. Wtórne czynniki zapowiadają pojawienie się pierwotnych czynników [Tavris, Wode 1999].

Od samego początku badań nad uczeniem się istniały dowody na to, że organizmy mają różne oczekiwania co do wzmocnień. Tinklepaugh (1928) wykazał, że małpy są rozczarowane, gdy oczekiwane wzmocnienie (kawałek banana) był zastępowany mniej cenionym wzmocnieniem (sałatą). Wynik ten wykazuje, że czynnik wzmacniający stanowi element asocjacji.

Corwill i Rescorla (1985;86;88) twierdzą, że organizmy budują asocjacje zawierające trzy elementy: bodziec, reakcja i wzmocnienie. Wykazali oni, że organizmy mogą nauczyć się oczekiwania specyficznych wzmocnień na specyficzne reakcje [Anderson 1998].

W eksperymencie przeprowadzonym przez St. Claire-Smitha i MacLarena (1983) szczury, umieszczone w skrzynce Skinnera uczono, że naciśnięcie dźwigni wywołuje dźwięk. Następnie tą grupę szczurów ćwiczono w wiązaniu dźwięku z pokarmem, gdy w skrzynce nie było dźwigni, a inną grupę kontrolną ćwiczono w wiązaniu światła i pokarmu. Gdy w skrzynce ponownie pojawiła się dźwignia (tym razem pokarmu nie podawano) szczury nauczone związku dźwięk - pokarm, częściej naciskały dźwignię niż szczury z grupy kontrolnej. Reakcja naciskania dźwigni nie przynosiła rezultatów w postaci pokarmu, ale zwierzęta nauczyły się kojarzyć dźwignię z innymi doświadczeniami. Umiejętność tworzenia asocjacji pomiędzy reakcjami i obojętnymi skutkami stanowi krytyczny czynnik dla uczenia się złożonych łańcuchów reakcji, z których tylko ostatnia jest wzmacniana. Np. uczenie szczura przechodzenia przez labirynt opiera się na nagradzaniu po przejściu całego labiryntu bez nagradzania poszczególnych skrętów i załamań labiryntu [Anderson 1998].

Premack (1962) zajmował się badaniem zachowań wzmacniających inne zachowania. Stwierdził, że zachowania bardziej cenione wzmacniają zachowania mniej cenione. Jedzenie zazwyczaj wzmacnia bieganie w kole aktywności u głodnego szczura, gdyż jedzenie ma większą wartość niż bieganie [Zimbardo 1994]. Według Premack�a z uczeniem się związane są nierozerwalnie pary zachowań. Dla każdej pary zachowanie niezależnie oceniane jako bardziej prawdopodobne, jest nagrodą dla zachowania mniej prawdopodobnego. Np. możliwość robienia czegoś co się lubi może być nagrodą czegoś co się lubi mniej. Jeżeli np. pies przed wyjściem z domu siedzi spokojnie przed drzwiami nagrodą jest dla niego wyjście na spacer, gdyż jest to bardziej preferowane zachowanie [www.kliker.pieski.eu.org/Teoria/ zasada_Premack].

Najlepszy efekt wzmocnienia wyjaśnia teoria deprywacji zachowania odkryta przez Timberlake'a i Allison'a w 1974 roku. Zakłada ona, że narzucane organizmowi ograniczenia zaburzają podstawowe, spontaniczne relacje między wykonywanymi przez niego zachowania. Jeżeli pozostawi się organizmowi całkowitą swobodę w rozporządzaniu własną aktywnością, to rozdzieli on czas poświęcony na różne zachowania w sposób dla niego optymalny i najprzyjemniejszy.

|

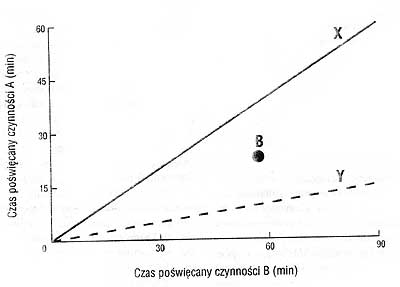

| Rys. 1. Wykres przedstawiający czas poświęcony każdej z wykonywanych czynności. |

Punkt B jest punktem zadowolenia, oznaczający dla jednostki optymalne rozłożenie czasu na zachowania A i B, mierzone w warunkach całkowitej swobody. Linie X i Y reprezentują różne ograniczenia narzucone na oba zachowania. Linia x wyznacza warunki, w których zachowania A wzmacnia zachowanie B. Linia Y wyznacza warunki, w których zachowanie B wzmacnia zachowanie A [Ostaszewski 2001].

Punkt B jest punktem zadowolenia. Punkt ten może zmieniać swoje położenie w zależności od warunków środowiskowych. Jeżeli zostaną wprowadzone ograniczenia do zachowań, spowoduje to dążenie organizmu do przywrócenia równowagi między czynnościami, a punktem zadowolenia. Jeżeli narzucone ograniczenie powoduje, że natężenie reakcji zależnej nie pozwala na wykonanie reakcji niezależnej, jednostka oddala się od punktu zadowolenia. Wywoła to taki wzrost natężenia reakcji zależnej, aby być jak najbliżej punktu zadowolenia. W ten sposób zastaje osiągnięty efekt wzmocnienia pozytywnego. Jeżeli natomiast ograniczenie powoduje, że natężenie reakcji zależnej zmuszą jednostkę do zwiększenia natężenia reakcji niezależnej, wówczas oddala się ona od punktu zadowolenia. Wywołuje to spadek natężenia reakcji zależnej. Efekt nazywany jest karą [Ostaszewski 2001].

2.4.4. WYGASZANIE

Jest to proces, w którym wyuczona wcześniej reakcja przestaje się pojawiać na skutek usunięcia czynnika wzmacniającego lub zaprzestania na jakiś czas podawania tego czynnika. Na początku wygaszania, reakcja może się nawet nasilić, lecz później stopniowo słabnie i wygasa [Tavris, Wode 1999]. Skinner zbadał, że warunkowania sprawczego nie można "wygasić do zera" i możliwe jest przywrócenie wygaszonej reakcji. Nazywane jest to warunkowaniem powtórnym. Polega na ponownym wzmacnianiu reakcji, której prawdopodobieństwo częstszego występowania zwiększa się [Skinner 1995].

Brak wzmocnienia w celu wygaszenia reakcji, wywołuje efekt emocjonalny u zwierzęcia. Początkowo szybkość i siła reagowania osiąga wartość maksymalną, jednak jeżeli żadna reakcja nie jest wzmacniana, zmniejsza się siła z jaką osobnik reaguje [Skinner 1995].

Niepożądana reakcja zostaje wygaszona tylko wtedy, gdy rzeczywiście można wyeliminować wszystkie czynniki wzmacniające. Całkowite ich wyeliminowanie jest trudne do zrealizowania poza laboratorium. Proces wygaszania jest, więc skuteczniejszy, gdy wycofanie czynników wzmacniających połączone zostanie z wzmacnianiem pozytywnym w celu zwiększenia prawdopodobieństwa pożądanej reakcji [Zimbardo 2001]. Np. jeżeli treser chce wygasić skakanie psa przy powitaniu powinien wzmacniać siadanie psa. Szybciej zostanie wyeliminowane niepożądane zachowanie, ponieważ siadanie będzie dla psa przynosiło korzyści.

2.4.5. MOTYWACJA

Wykonywanie przez organizm wielu zachowań jest zależnie od okoliczności, jak również od celów. Są to procesy kierowane przez pewne potrzeby lub cele, a kończące się, gdy potrzeby są zaspokajane lub cele osiągane [Zimbardo 2001].

Wszystkie motywowane działania składają się z trzech faz:

1. reakcja wzbudzenia

2. uruchomienia czy zainicjowania specyficznych mechanizmów i czynności

3. wytrwałego dążenia do pewnych celów przy zastosowaniu różnych sposobów [Altman 1966].

Zwierzę "nie motywowane" zazwyczaj pozostaje w bezruchu - może np. leżeć na boku, odprężone i senne. Wystąpienie stanu motywacyjnego przejawia się najpierw jako reakcja wzbudzenia, wzrost czujności i oznaki pobudzenia ruchowego. Druga faza, inna w różnych stanach motywacyjnych, polega na zainicjowaniu i podjęciu specyficznych czynności, które mogą zaspokoić potrzeby organizmu. Na koniec, jeśli cel nie zostanie od razu osiągnięty, zwierzę będzie uparcie dążyć do celu swego motywowanego zachowania, próbować różnych sposobów, dopóki nie osiągnie celu lub póki jego siły się nie skończą [Altman 1966].

2.4.6. SPOSOBY UZYSKIWANIA POŻĄDANYCH ZACHOWAŃ

Istnieje kilka sposobów, za pomocą których można wywołać pożądaną reakcję, niezależnie od tego, czy jest to reakcja znana dla organizmu, czy całkowicie nowa. Wyróżnia się kilka metod nakłaniania jednostki do wykonania pierwszej reakcji, tak aby można było ją wzmocnić [Zimbardo 1994].

Jedna z nich jest zwiększanie motywacji. Polega na pobudzeniu organizmu do reagowania co zwiększa prawdopodobieństwo, że jedna z reakcji będzie poprawna np. naelektryzowanie kraty podłogowej skłoni szczura do biegania, dzięki czemu będzie mógł odkryć drogę ucieczki.

Do motywowania działania można użyć zagrożeń lub obietnic przyszłej nagrody, jak również stanów deprywacji lub przykrych bodźców. Czynniki motywacyjne mogą mieć niekorzystne następstwa. Nie zaleca się podnoszenia poziomu motywacji w przypadku nieznanych zachowań [Zimbardo 1994].

Inną metodą jest zmniejszanie zahamowań. W przypadku gdy organizm nabył już umiejętność potrzebną do wykonywania poprawnej reakcji, lecz mimo odpowiednich warunków motywacyjnych jej nie wykonuje, możliwe jest, że reakcja ta jest zahamowana lub stłumiona. Np. nieśmiałe dziecko znające odpowiedź na pytanie nauczyciela, nigdy nie uzyska wzmocnienia, jeśli nie podniesie ręki i nie odpowie na pytanie. Zabieranie głosu na lekcji jest dla niego bardzo stresujące. Jedynie usunięcie czynników hamujących może pomóc w wywołaniu pożądanej reakcji [Zimbardo 1994] .

Kolejnym sposobem uzyskiwania zachowań jest strukturalizacja otoczenia. Ucząc zwierzę naciskania dźwigni, dziobania przycisku, otwierania zasuwy, można zwiększyć prawdopodobieństwo tych zachowań usuwając rozpraszające, nieistotne bodźce, upraszczając otoczenie. Przedmioty służące do manipulowania (dźwignia, przycisk itp.) powinny być bardziej widoczne niż elementy otoczenia.

Stosując przymus można szybko wywołać reakcje, jednak jego konsekwencje przynoszą skutki uboczne. Technika ta polega na fizycznej pomocy w wykonywaniu kilku pierwszych zachowań. Np. ucząc psa przewracania trener najpierw podaje sygnał słowny, a następnie przewraca psa nagradzając tą reakcje dopóki zwierzę nie nauczy się tego zachowania [Zimbardo 1994].

Organizmy mogą uczyć się poprzez obserwowanie innych organizmów. Odgrywa to ważną rolę w uczeniu się społecznym, zarówno u zwierząt jak i u ludzi. Jednak nadmierne naśladowanie może ograniczyć własną inicjatywę danej jednostki i nauczyć ją konformizmu. Może także prowadzić do "podchwytywania" mnóstwa innych reakcji, nie koniecznie związanych z pożądaną reakcją [Zimbardo 1994].

Bardzo ważną metodą ucznia jest kształtowanie. Jest ona przydatna zwłaszcza podczas uczenia nowych, nieznanych zachowań i sekwencji reakcji. Kształtowanie polega na wzmacnianiu początkowych reakcji, które mają związek z ostatecznym zachowaniem, ale mogą w niewielkim stopniu przypominać jego końcową formę. Jeżeli uczy się szczura naciskania dźwigni, za reakcję początkową uważa się każdy ruch szczura w kierunku dźwigni np. zwrócenie ciała w tym kierunku, unoszenie łapek i opieranie się o dźwignię. Nagradzane są zachowania coraz bliższe oczekiwanej reakcji. Wymagania muszą być zwiększane bardzo powoli. Reakcja szczura będzie stopniowo ulegała zmianie w pożądanym kierunku [Skinner 1995].

Skinner uważa, że bardziej złożone zachowania są sekwencjami reakcji z których każda reakcja jest początkiem dla następnej. Aby nauczyć złożonego zachowania, należy rozpocząć od pierwszego kroku i uczyć każdego elementu łańcucha. Dzięki kształtowaniu reakcji można uzyskać skomplikowane zachowania. Jednak pewne czynniki mogą przeszkadzać w kształtowaniu reakcji. Brelandowie, którzy uczyli różne gatunki zwierzęt bardzo różnorodnych zachowań odkryli u nich tendencje instynktowne. Uczyli oni świnię brania dużej, drewnianej monety i umieszczania jej w skarbonce. Świnia w nagrodę dostawała pokarm. Przez kilka tygodni dobrze wykonywała to zachowanie, ale później drewnianą monetę zakopywała lub podrzucała do góry. Świnia zaczęła obchodzić się z monetą jak z pokarmem. Zachowanie to stanowiło element naturalnego zachowania związanego z gromadzeniem pokarmu u świń. Brelandowie próbowali też nauczyć szopy umieszczania monet w koszu. Po pewnym czasie szopy zaczęły wykonywać zachowania odpowiadające praniu i czyszczeniu jedzenia. Stanowiło to element specyficznego gatunkowo dla szopów zachowania wiążącego się z gromadzeniem pokarmu. Instynktowne zachowania organizmu mogą przezwyciężyć reakcje starannie kształtowane [Anderson 1998].

Każdy ze sposobów ucznia ma pewne zalety i wady. Wybór metody jest często uzależniony od potrzeb uzyskiwania zachowań, od tego czy mają dawać wyniki natychmiastowe, czy też bardziej trwałe, długoterminowe [Zimbardo 1994].

2.4.7. ROZKŁADY WZMOCNIEŃ

Behawioryści opracowali podstawowe procedury stosowania wzmocnień, które mówią o tym, jak często i w jakich warunkach dane zachowanie zostaje wzmocnione. Są to:

1. rozkład ciągły - polega na wzmacnianiu każdej poprawnie wykonanej reakcji;

2. rozkład o stałych odstępach czasowych - wzmacniana jest reakcja wykonana tylko po upływie stałego czasu od poprzedniego wzmocnienia;

3. rozkład o zmiennych odstępach czasowych - wzmacnianie pojawia się w różnych odstępach od poprzedniego wzmocnienia;

4. rozkład o stałych proporcjach - wzmocnienie pojawia się po stałej liczbie reakcji;

5. rozkład o zmiennych proporcjach - wzmocnienie pojawia się po pewnej liczbie reakcji, lecz liczba ta jest zmienna [Ostaszewski 2001].

Zachowania wzmacniane w sposób ciągły są podatne na wygaszenie. Jeżeli natomiast stosowany jest rozkład o zmiennych proporcjach jest on bardziej odporny na wygaszenie, ponieważ osobnik nie może przewidzieć kiedy pojawi się nagroda. Podstawą wszelkich gier hazardowych jest zmienny schemat wzmocnień. Ludzie stają się niewolnikami hazardu, gdyż nie mogą przewidzieć, czy wygrają fortunę, czy też nic. Wzmocnienie w postaci pieniędzy może wystąpić już przy pierwszej grze, a może równie dobrze przy dziesiątej [Pryor 1985].

Uczenie się jest zazwyczaj szybsze, jeśli reakcja, której osobnik się uczy, będzie wzmacniana za każdym razem. Gdy już reakcja zostanie utrwalona, będzie bardziej odporna na wygaszenie, jeśli będzie nagradzana nieregularnie.

Różne rozkłady wzmocnień mogą być łączone w łańcuchy, w których dopiero wykonanie wymagań ostatniego rozkładu powoduje wzmocnienie. Warunkiem takich łańcuchów jest podanie sygnału informującego, na zakończenie każdego z etapów pośrednich, że osobnik wykonuje to dobrze i na koniec zachowania dostanie nagrodę (wzmocnienie) [Ostaszewski 2001].

Niezależnie od rozkładu wzmacniania czynniki wzmacniające, należy podawać szybko, aby były skuteczne. W przypadku długiego upływu czasu między ostatnią reakcją lub łańcuchem reakcji, efekt wzmocnienia zostaje całkowicie zaprzepaszczony. Ucząc niektórych zachowań czasem nie możliwe jest szybkie podanie wzmocnienia, dlatego jednym z rozwiązań tego problemu jest stosowanie warunkowych czynników wzmacniających, które zastępują tymczasowo pierwotne czynniki wzmacniające [Zimbardo 1994].

Zdarza się, że organizm ma do wyboru dwa lub więcej sposobów na uzyskanie w tym samym czasie wzmocnień. Np. szczur w skrzynce ma do wyboru dwie dźwignie, które są związane z różnymi rozkładami wzmocnień. Wiąże się to z dokonaniem wyboru przez szczura w celu wybrania odpowiedniej dźwigni.

2.4.8. DOKONYWANIE WYBORU

Prawo dopasowania jest podstawowym prawem związanym z wyborem dokonywanym przez organizmy. Mówi o tym, jak rozdysponowują one swoimi reakcjami i czasem między uzyskaniem wzmocnienia. Wybór mniejszej, ale szybciej otrzymanej nagrody zamiast większej, ale bardziej odroczonej jest nazywany impulsywnością. Samokontrolą zaś nazywany jest wybór większej, bardziej odroczonej nagrody zamiast mniejszej, choć szybciej osiągalnej [Ostaszewski 1997].

Rachlin i Green przeprowadzili w 1972 roku badania, w których gołębie miały do wyboru dwie nagrody - mniejszą natychmiastową i większą odroczoną o 4 sekundy. Większa nagroda był preferowana bardziej niż mniejsza. Mimo to gołębie wybierały mniejszą, natychmiastową nagrodę. Nie były w stanie czekać 4 sekund na większą. Zachowywały się więc impulsywnie. Po pewnym czasie zmieniono odroczenie obu nagród dodając stopniowo po kilka sekund do czasów oczekiwania na wzmocnienie. Zwierzęta ciągle preferowały mniejsze, szybsze nagrody. Jednak gdy czas odroczenia obu nagród zbliżył się do 10 sekund, czyli na pierwszą nagrodę zwierzęta czekały 10 sekund, a na drugą 14 sekund, gołębie zaczęły częściej wybierać większą nagrodę, mimo że była odroczona bardziej, a czas rozdzielający obie nagrody utrzymywał się na tym samym poziomie co na początku badania. Gołębie zmieniły swoje preferencje i wykazały zdolność do samokontroli [Ostaszewski 1997].

Zwierzęta wybierają wcześniejszą nagrodę, która jest mniejsza, rezygnując z większej, bardziej preferowanej, ale odroczonej. Ostaszewski pisze, że zwierzęta często stają przed wyborem: zaakceptować mniejszy, łatwiej dostępny pokarm, czy kontynuować poszukiwanie większego pokarmu. Odraczanie, czyli poszukiwanie pokarmu większego, może wiązać się z jego zepsuciem się lub zdobyciem przez osobnika konkurencyjnego. Zwierzęta wybierają więc pokarm natychmiastowy, mimo że jest często mniejszy. Jednak w przypadku zwiększenia odroczeń obu nagród są w stanie do samokontroli, czyli wybrania nagrody większej, dłużej oczekiwanej [Ostaszewski 1997].

2.4.9. NAGRODA I KARA

Podczas uczenia się organizmy mogą doświadczać, w odpowiedzi na ich reakcje, nagród jak i kar. Nagrody wiążą się z przyjemnymi konsekwencjami dla organizmu. Już w starożytności pojawiło się przekonanie o poszukiwaniu przyjemności przez wszystkie organizmy i unikaniu kar z czym wiąże się ból i cierpienie. Stwierdzono, że organizmy wykorzystując zależności, których się nauczyły, wybierają najkorzystniejsze dla siebie zachowania. Zachowują się więc w sposób racjonalny [Anderson 1998].

Anderson (1998) podaje przykład czterech reakcji, które zwierze może wybrać:

R1- reakcja zwiększająca ilość dostępnego pokarmu

R2- zwiększa częstotliwość otrzymywania wstrząsów

R3- zmniejsza tempo otrzymywania pokarmu

R4- zmniejsza częstotliwość otrzymywania wstrząsów

Zwierzę będzie wybierało tylko reakcje R1 i R4 w zależności od tego, jak ważne jest otrzymywanie pokarmu do unikania wstrząsów. Będzie się zachowywało racjonalnie nie wybierając reakcji R2 i R3, gdyż one wiążą się z nieprzyjemnością.

Zwierzę potrafi więc eliminować zachowania, które nie prowadzą do celu, czyli do otrzymania pokarmu lub uniknięcia wstrząsów [Sadowski, Chmurzyński 1989].

Karanie ma także swoich zwolenników, którzy twierdzą, że tylko dzięki karaniu można osiągnąć doskonałe efekty. Johnson (1972) pisze: " Z żadnych danych nie wynika, że którakolwiek z tych procedur (wygaszanie, nasycenie, zmiana bodźca, ograniczenie fizyczne) daje efekty tak natychmiastowe, trwałe i w ogóle skuteczniejsze, jak te, które przynosi właściwe zastosowanie technik karania." [Zimbardo 1994].

Badano także efektywność karania i to co na nią wpływa. Wynika z nich, że kara powinna być stosowana z jak największym natężeniem. N.E. Miller (1960) stwierdził, że gdy rozpoczynano od łagodnych kar, a następnie zwiększano ich surowość organizm stawał się mniej wrażliwy na karę i najsurowsze kary nie były tak skuteczne, jak wówczas, gdy wprowadzono je na początku. Azrin, Holz i Hake (1963) zbadali, że efektywność kar była mniejsza, gdy karane były tylko niektóre reakcje. Czasami kara może być tak skuteczna, że już jednokrotne jej użycie eliminuje zachowanie. Np. szczura umieszczono na platformie pod która znajdowała się siatka. Gdy zwierzę stawało na siatce, otrzymywało bolesny wstrząs. Tylko jedno doświadczenie wystarczyło, aby szczur ponownie nie schodził na siatkę. Aby karanie było skuteczne musi nastąpić od razu po reakcji. Nawet kilkusekundowe opóźnienie nie przynosi pożądanych efektów, czyli wyeliminowania pewnych zachowań. Zachowanie może być także podtrzymywane dlatego, że pozwala na uniknięcie bodźców awersyjnych. Zwierzę uczy się wykonywać pożądaną reakcję po zaobserwowaniu bodźca dyskryminującego, który sygnalizuje pojawienie się bodźca awersyjnego. Np. pies umieszczony w skrzynce, którą poddawano wstrząsom, uczy się przeskakiwać barierę skrzynki i w ten sposób uniknąć wstrząsu. Organizm może nauczyć się zachowania, które odsuwa w czasie wydarzenie awersyjne. Jest to tzw. odraczanie pojawienia się kary [Anderson 1998]. Np. ludzie myjąc zęby odsuwają awersyjne konsekwencje, czyli ból zębów.

Jednak kara przynosi więcej ubocznych skutków, a zwłaszcza niewłaściwe jej stosowanie, niż stosowanie pozytywnego wzmacniania.

Skutek kary jest czasami krótkotrwały, ściśle uzależniony od obecności osoby karzącej lub okoliczności jej stosowania. Zachowanie jest zahamowane tylko w obecności kojarzonego z karaniem środowiska. Według Sidmana, jeżeli karzemy psa uderzając ręką, już sama podniesiona ręka stanie się karą. Środowisko w którym pies jest karany stanie się karą [www.kliker.pieski.eu.org/Teoria/Sidman_Coercion].

Karanie za niepożądane zachowanie jest często stosowane z dużym opóźnieniem. Zwierzę często nie jest w stanie skojarzyć otrzymania kary z zachowaniem, za które ją otrzymało. Prowadzi to do strachu , a nawet agresji [Ulrich, Azarin 1962]. Może doprowadzić do zahamowania wszystkich zachowań, dobrych i złych. Sidman twierdzi, że osobnik karany uczy się robić tylko to co konieczne, nie uczy się on niczego nowego. Groźba kary zawężą horyzonty uczenia się, powodując strach przed próbowaniem nowych zachowań, poznawaniem środowiska.

Kara dostarcza także niewiele informacji. Jeżeli następuje po złym zachowaniu, może ukaranemu wskazać, czego nie powinien robić. Nie wskazuje natomiast jak powinien postępować [Tavris, Wade 1999].

"Nie uczymy szybkiego uczenia się, kiedy karzemy za to, że uczy się za wolno, ani przypomina sobie czego się nauczył, kiedy karzemy go za zapominanie, ani logicznego myślenia, karząc go za brak logiki." [Skinner 1968]

Nagroda w przeciwieństwie do kary daje możliwość próbowania innych zachowań i ciągłego uczenia się. Pies nie boi się przewodnika i tego, że za złe zachowanie zastanie ukarany. Nagradzanie kontroluje zachowania, podobnie jak karanie, różnicą jest brak skutków ubocznych. Sidman uważa, że: "zarówno pozytywne jak i negatywne wzmocnienie nauczą tego, czego wymagasz, ale one nauczą tez przy okazji innych rzeczy. I właśnie w tym punkcie wzmocnienia się różnią. Pozytywne wzmocnienie daje nam wolną rękę w zaspokajaniu ciekawości, w próbowaniu nowych rzeczy. Negatywne wzmocnienie wpaja nam wąski repertuar zachowań, ucząc lęku przed nowościami i eksperymentowaniem."

W niektórych przypadkach, jeżeli chodzi o bardzo niebezpieczną sytuację, karanie jest konieczne. Nie przyniesie ono jednak skutków ubocznych, gdy będzie to karanie sporadyczne, a całe postępowanie ze zwierzęciem opiera się na nagradzaniu. Nagradzanie przynosi lepsze efekty niż karanie, zwłaszcza, że efektywne karanie musi być bardzo precyzyjnie stosowane, żeby przyniosło oczekiwane skutki [www.kliker.pieski.eu.org /Teoria/Sidman_Coercion].

Jak pisze Bob Bailey, który szkoli zwierzęta od kilkudziesięciu lat stosując głównie nagradzanie, karanie wymaga więcej doświadczenia, lepszego wyczucia czasu niż nagradzanie.

Szkoła Główna Gospodarstwa Wiejskiego

Wydział Nauk o Zwierzętach

KLIKEROWE SZKOLENIE PSÓW

Praca magisterska wykonana przez Agnieszkę Prymaka

pod kierunkiem prof. dr hab. Kazimierza Ściesińskiego

w Katedrze Szczegółowej Hodowli Zwierząt.

Warszawa 2004